Nutzung des DataCrawlers (Data Scraping)

Allgemeine Einleitung

In dieser Anleitung erklären wir Ihnen den Ablauf innerhalb der App Data Crawler. Sie sollten technisches Wissen im Bereich HTML und Verständnis im Bereich Webverbindungen mitbringen. Die Software läuft hier direkt in Ihrem tricoma System. Somit findet ein direktes Data Scraping in Ihrem tricoma statt, ohne das Dritte Dienste benötigt werden.

Nutzung des DataCrawlers (Data Scraping)

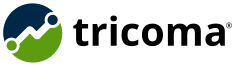

Genereller Ablauf innerhalb der App

- 1. Anlage der Webseite und Konfiguration

- 2. Crawlen der Webseite

- 3. Data Scraping: Verarbeitung der gefundenen Daten anhand angelegter Regeln

- 4. Anlage als Produkt innerhalb der App DataCrawler mit Übernahme in die App Produkte

Nutzung des DataCrawlers (Data Scraping)

Data Scraping erklärt

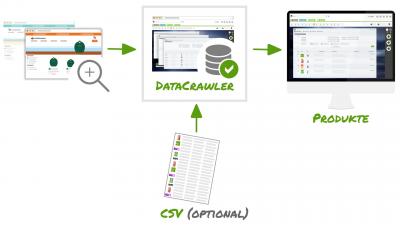

Beim Data Scraping werden einzelne Seiten ausgewertet und Inhalte daraus ausgelesen. Diese werden dann in strukturierter Form gebracht.

Beispiel:

- 1. Produktbild(er)

- 2. Produkttitel / Hersteller

- 3. Preis, wobei dieser auch durch eine hinterlegte CSV Datei ergänzt werden kann

- 4. Beschreibung

- 5. Attribute wie Größe, Farbe, Höhe, Material, EAN, Artikelnummer...

Nutzung des DataCrawlers (Data Scraping)

Einrichtung und Nutzung

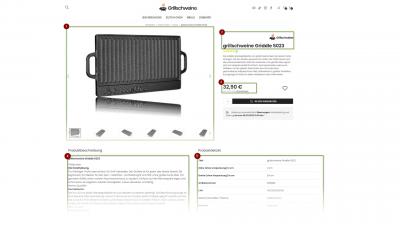

Anlage einer Webseite

Um mit dem Crawlen zu starten ist es nötig eine neue Webseite innerhalb der App anzulegen. Hierbei muss die URL definiert werden.

Nutzung des DataCrawlers (Data Scraping)

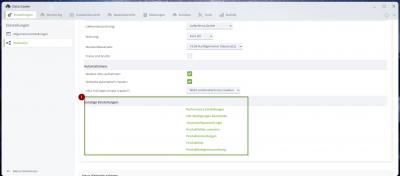

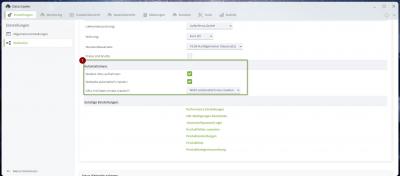

Vornehmen von Grundeinstellungen

Im nächsten Schritt sollten Grundeinstellungen wie die Lieferantenzuordnung vorgenommen werden.

Nutzung des DataCrawlers (Data Scraping)

Einrichtung der Datenverarbeitung

Die Einrichtung der Datenverarbeitung ist der komplexeste Part beim auswerten von Inhalten. Derzeit sind folgende Verarbeitungsklassen vorhanden:

- Loginklasse: Die Loginklasse bietet die Möglichkeit sich vor dem Aufruf einer URL der Webseite einzuloggen. Der Login wird danach in einer Session geschreiben, so das nicht bei jedem Webseitenaufruf ein erneuter Login nötig ist. Aktivieren Sie dies nur wenn es benötigt wird.

- Kategorieklasse: Die Kategorieklasse bietet derzeit wenig Funktionsumfang und dient derzeit nur dazu eine gecrawler URL als eine Kategorieadresse zu identifizieren. Diese lassen sich später filtern, um z. B. explizit nochmals Kategorieadressen erneut abzurufen

- Produktklasse: Diese Klasse ist die wichtigste Klasse, da diese die Produktdaten aus der Webseite ausliest und verarbeitet. Diese ist auch dafür zuständig neue Produkte anzulegen. Details finden Sie in folgender Anleitung: Nutzung des DataCrawlers (Data Scraping)

- Suchklasse: Die Suchklasse dient dazu Suchanfrage auf der Webseite auszuführen. Hier können Sie eine URL mit einem Datenfeld definieren, welches mit Ihren Suchanfragen über ein entsprechendes Tool befüllt werden kann.

Nutzung des DataCrawlers (Data Scraping)

Sonstige Einstellungen

- Performance Einstellungen: Definieren Sie mit wie viel Aufrufen die Webseite ausglesen werden darf.

- URL Bedingungen bearbeiten: Hier sollten Sie Bedingungen definieren, so das nur URLs aufgenommen werden, welche diesen Bedingungen entsprechen oder eben nicht entsprechend.

- .htaccess/htpasswd Login: Sie können hier Zugangsdaten definieren, falls die Webseite mit einem htpasswd Passwortschutz gechützt ist

- Produktfelder zuweisen: Hier können Sie gecrawlte Inhalte (Data Scraping) Ihren Produktdatenfeldern zuweisen (Arbeiten mit Produktdaten aus dem Data Scraping)

- Produkteinstellungen: Definieren Sie hier diverse Produkteinstellungen welche unter anderem bei der Produktanlage gelten sollen

- Produktliste: Hier können Sie zusätzlich eine CSV Datei (z. B. Händlerpreisliste) hinterlegen. Dann werden die gefundenen Preise durch die aus der Liste ersetzt. Auch können weitere Informationen wie die EAN Nummer ergänzt werden, sofern diese nicht im Shop vorhanden sind.

- Produktkategoriezuordnung: Weisen Sie hier die gefundenen Produktkategorien Ihren Produktkategorien zu. Diese Zuordnung wird bei der Produktanlage verwendet.

Nutzung des DataCrawlers (Data Scraping)

Automatismen

Es empfiehlt sich die Automatismen

erst zu aktivieren, wenn vorab das crawlen über die Tools manuell sauber funktioniert hat.

Folgendes sollte vorab verifiziert werden:

- 1. Werden vorhandene URLs mit den Code 200 erkannt (Prüfbar in der Crawlerübersicht)

- 2. Wurden URLs ausgeschlossen, welche man gar nicht crawlen möchte. z. B. doppelte Produkturls, Blogseiten oder auch endlose Kategoriefilter

3. Sind die Daten welche gecrawlt werden inkl. Attribute sauber und in der richtigen Form

Nutzung des DataCrawlers (Data Scraping)

Crawlen mit Sessions

Beim Crawlen wird mit sogenannten Sessions gearbeitet. Somit kann sich tricoma auf der jeweiligen Webseite einloggen und erneute Abfrufe mit der identischen Session vornehmen. Allgemein ist es auch so, das durch die Sessions ein Limit an gleichzeitiger Abrufe an den Zielserver erfolgen kann. Dies hilft eine Überlastung des Zielservers zu vermeiden.

Nutzung des DataCrawlers (Data Scraping)

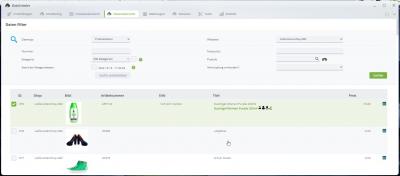

Crawlerübersicht

In der Crawlerübersicht können Sie einsehen welche URLs bereits aufgerufen wurden. Auch können Sie URLs neu abfrufen lassen, wenn Sie z. B. Ihr Regelwerk für die Verarbeitung von Daten (Data Scraping) geändert haben.

Nutzung des DataCrawlers (Data Scraping)

Datenübersicht

In der Datenübersicht könne Sie Ihre gecrawlten Daten einsehen und z. B. in die Produktverwaltung übernehmen. Details hierzu finden Sie hier

Arbeiten mit Produktdaten aus dem Data Scraping.

Nutzung des DataCrawlers (Data Scraping)

Im Reiter Monitoring können Sie die Auslastung Ihres Crawler einsehen. Aus technischen Gründen hat der Crawler folgende Limitierungen:

tricoma Premium

- Maximale Anzahl an URLs: 250.000

- Anzahl an Produkten: 100.000

- Anzahl an Bilder: 200.000

- Maximalgröße vom Cache: 2.000MB (Zwischenspeicher der Inhalte ohne Bilder)

- Anzahl URL Aufrufe pro 24 Stunden: 21.600

tricoma Enterprise

- Maximale Anzahl an URLs: 1.000.000

- Anzahl an Produkten: 500.000

- Anzahl an Bilder: 1.500.000

- Maximalgröße vom Cache: 10.000MB (Zwischenspeicher der Inhalte ohne Bilder)

- Anzahl URL Aufrufe pro 24 Stunden: 86.400

Sind die Limitierungen erreicht, so müssen die Daten oder Aufrufe reduziert werden. Vorher pausieren alle automatischen Prozesse innerhalb der App.

Tipp: Nutzen Sie die URL Bedingungen um unnötige URLs nicht zu crawlen und somit Speicher im Cache und URLs zu sparen.

Nutzung des DataCrawlers (Data Scraping)

Die Tools vom DataCrawler sind sehr mächtig. So haben Sie die Möglichkeit manuell das Crawlen zu starten, die sitemap.xml einer Seite einzureichen oder Suchanfragen auf der Webseite auszuführen.

Nutzung des DataCrawlers (Data Scraping)

Konfiguration des User Agents

In den Allgemeine Einstellungen haben Sie die Möglichkeit einen User Agent zu definieren. Das ist sogesehen der "Softwaretyp" mit welchem die Webseite abefragt wird

Häufig reagieren Webseiten unterschiedlich je nach User Agent. Beispiele:

- Google Chrome, Firefox, Bot: Gibt man sich als Browser aus, so werden häufig Inhalte nachgeladen um ein besseres Besucherergebnis zu haben. Sie sollten sich daher nicht als ein solcher ausgeben

- Bot: Standardmäßig gibt sich tricoma als "tricoma Bot" aus. Aufrufe als Bot sind in den meisten Fällen empfohlen, da Webseite hier im regelfall kein JavaScript laden.

Nutzung des DataCrawlers (Data Scraping)

Hinweise zur Datenqualität

Die Datenqualität richtige sich inbesondere nach dem Aufbau der zu crawlenden Webseite.

Der Crawler versucht möglichst HTML typische Attribute wie H1, Schema.org, Meta Tags oder itemprop zu beachten.

Die Datenqualität kann immer durch eigene Klassen gesteigert werden.

Geschützte Daten, Hintergrundabfragen

Der Crawler führt kein JavaScript aus. Sollte die Webseite somit mit Hintergrundabfragen Daten generieren, so können diese vom DataCrawler nicht abgefragt werden.

Hierzu müsste eine eigene Produktklasse entwickelt werden, welche dies dann simuliert.

Beachten Sie hierbei immer den Punkt "Rechtliche Anmerkungen" und Gesetze dazu.

Rechtliche Anmerkungen

Beachten Sie bitte folgende rechtliche Anmerkungen

- Generell unterliegen Texte und Bilder von Webseiten dem Urheberrecht

- Sie sollten vor dem Crawlen den Webseitenbetreiber (Lieferant oder Hersteller) um Erlaubnis fragen

- Es gibt ein Urteil zum Thema “Web Scraping”, welches dies erst einmal erlaubt, sofern die Daten nicht geschützt werden - Referenz: BGH, 30.04.2014 - I ZR 224/12

- Es gibt ein Datenbankherstellerrecht (Deutschland), welches es Data Scraping Software, Vergleichsportale, Suchmaschinen etc. dazu berechtigt gecrawlte Daten zu nutzen und Vergleiche anzustellen